[AWS re:Inforce 2025] Best Practice for evaluating Amazon Bedrock Guardrails for Gen AI Workloads

OVERVIEW

들어가며

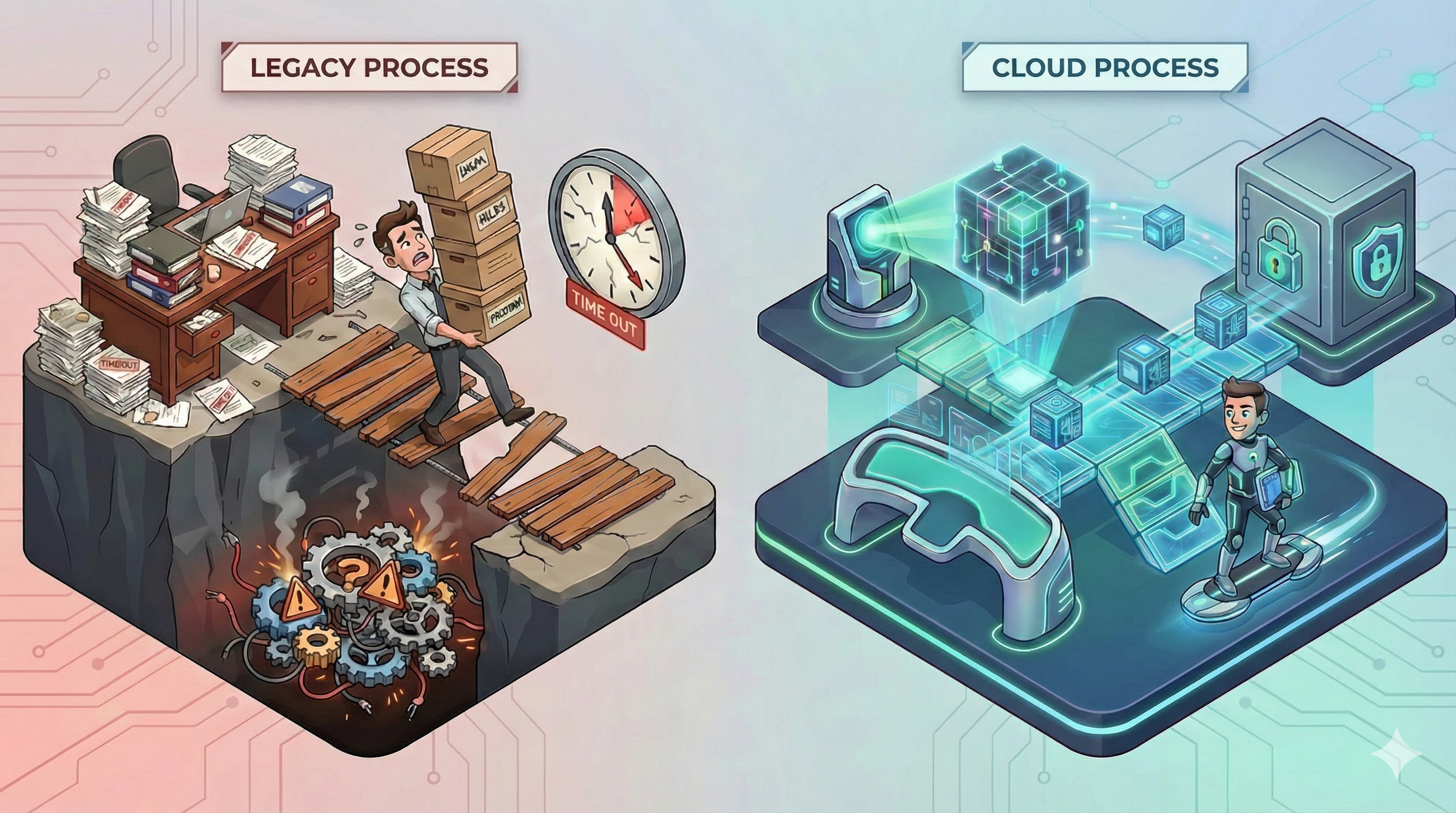

생성형 AI(GenAI) 프로젝트가 실험 단계를 넘어 실제 프로덕션 환경으로 나아가는 길목에서, 많은 기업이 ‘보안에 대한 불확실성’이라는 큰 장벽에 부딪히고 있습니다. 저 또한 GenAI 워크로드를 안전하게 배포하고 운영하기 위한 구체적이고 실질적인 방안에 대해 깊은 고민을 하고 있었습니다.

이번 AWS re:inforce 세션을 통해, 저는 AWS의 네이티브 보안 서비스인 Amazon Bedrock Guardrails가 이러한 불확실성을 어떻게 해소해 주는지 배우고 싶었습니다. 특히, 단순히 가드레일의 기능을 아는 것을 넘어, 이를 어떻게 체계적으로 구성하고, 가장 중요하게는 어떻게 테스트하여 최적화할 수 있는지에 대한 실질적인 방법론과 인사이트를 얻고자 했습니다.

Bedrock Guardrails – GenAI를 위한 안전장치

세션의 서두에서 발표자 Corey Smith는 GenAI를 ‘언제 사직서를 낼지 모르는 반항적인 인턴’에 비유하며, 그 잠재적 위험성과 강력한 보안 기반의 필요성을 강조했습니다. 그가 제시한 핵심 해결책은 바로 Amazon Bedrock에 내장된 네이티브 보안 제어 기능, Bedrock Guardrails였습니다. 이는 사용자의 프롬프트와 모델의 응답, 즉 입출력 전체 과정에 대한 안전장치를 제공하는 역할을 합니다.

“What I most often hear from customers as a blocker on the path to production is uncertainty around security. They just feel like there’s a lot of unknowns. So what we want to do today is highlight the use of Bedrock, Bedrock Guardrails to provide a level of certainty and assurance.”

(제가 고객들로부터 프로덕션으로 가는 길에 가장 큰 장애물로 듣는 것은 보안에 대한 불확실성입니다. 미지의 영역이 너무 많다고 느끼는 것이죠. 그래서 오늘 우리는 Bedrock Guardrails 사용을 강조하여 확신과 보증을 제공하고자 합니다.)

Bedrock Guardrails는 여러 보안 정책의 집합체로 구성됩니다.

1️⃣ 거부 주제(Denied Topics) 정책을 통해, 자연어 설명과 몇 가지 예시만으로 특정 주제(예: 금융 챗봇의 투자 조언)에 대한 대화를 차단할 수 있습니다.

2️⃣ 혐오, 모욕, 폭력, 프롬프트 공격 등 다양한 유해 콘텐츠를 탐지하는 콘텐츠 필터(Content Filters)를 민감도(낮음, 중간, 높음)에 따라 세밀하게 조정할 수 있습니다.

3️⃣ 단어 및 구문 필터(Word Filters)를 통해 AWS가 관리하는 비속어 목록이나 기업이 정의한 특정 단어(예: 경쟁사 이름)를 차단하거나 마스킹할 수 있습니다.

4️⃣ 마지막으로, 민감 정보 필터(Sensitive Information Filters)는 PII(개인식별정보)를 탐지하여 수정(redact)하거나, 정규식(RegEx)을 통해 기업 고유의 민감 데이터를 정의하여 보호할 수 있습니다.

특히 인상 깊었던 점은 새롭게 출시된 ‘Apply Guardrail API’입니다. 이를 통해 Bedrock 외부에서 호스팅되는 모델에 대해서도 독립적으로 가드레일의 평가 기능을 호출할 수 있게 되어, 그 활용 범위가 대폭 확장되었습니다. 이는 Bedrock Guardrails가 단순히 Bedrock 서비스의 부가 기능이 아닌, 범용적인 LLM 보안 레이어로서 기능할 수 있음을 의미합니다.

가드레일은 ‘Day Zero’ 활동이다

Corey는 가드레일 적용이 단순히 프로덕션 배포 직전에 ‘덧붙이는(slap it on)’ 작업이 되어서는 안 된다고 거듭 강조했습니다. 가드레일은 솔루션을 설계하는 첫날, 즉 ‘Day Zero’부터 고려되어야 할 핵심적인 보안 전략이라는 것입니다. 이를 위해 그는 5단계의 체계적인 베스트 프랙티스를 제시했습니다.

“You don’t want to turn on a guardrail when you move to production. You should understand how the guardrail has been built, how it’s been tested, how it’s been validated, and you want to do this throughout the SDLC… You simply do not want to slap it on when you go to production.”

(프로덕션으로 전환할 때 가드레일을 켜기만 해서는 안 됩니다. 가드레일이 어떻게 구축되고, 테스트되고, 검증되었는지 이해해야 하며, 이는 SDLC 전반에 걸쳐 이루어져야 합니다… 단순히 배포 직전에 덧붙여서는 안 됩니다.)

가드레일 전략의 5단계를 아래와 같이 제시합니다:

1️⃣ 사용 사례 정의: 가장 먼저 챗봇의 목적과 입출력 방식을 명확히 정의합니다. 이를 통해 거부 주제, 필터링할 단어, 필요한 PII 탐지 유형을 결정할 수 있습니다.

2️⃣ 가드레일 전략 수립: 사용 사례에 맞춰 어떤 정책(거부 주제, 콘텐츠 필터 등)을 조합하여 가드레인을 구성할지 설계하는 ‘Day Zero’ 활동입니다.

3️⃣ 구성 및 반복적 테스트: 정책을 구성한 후, 테스트 프레임워크를 사용하여 다양한 프롬프트 테스트 케이스로 가드레일의 동작을 검증합니다. 기대와 다른 결과가 나올 경우, 거부 주제의 예시를 수정하거나 콘텐츠 필터의 민감도를 조정하며 최적의 설정을 찾아나갑니다.

4️⃣ IAM 정책을 통한 강제 적용: 테스트를 통해 검증되고 버전 관리되는 특정 가드레일만이 프로덕션 환경에서 사용되도록 IAM 정책의 조건문(conditional statements)을 사용하여 강제합니다. 이는 고품질의 가드레일 사용을 보장하는 핵심적인 통제 장치입니다.

5️⃣ 모니터링 및 재평가: CloudWatch 지표, 특히 ‘가드레일 개입(guardrail interventions)’ 지표를 지속적으로 모니터링합니다. 예상치 못한 개입이 자주 발생한다면, 이를 분석하여 사용 사례를 재평가하고 가드레일 정책을 지속적으로 개선해 나갑니다.

이러한 체계적인 접근 방식은 가드레일을 단순한 필터가 아닌, 비즈니스와 함께 진화하는 살아있는 보안 정책으로 만들어 줍니다.

결론

이번 AWS re:inforce GenAI 보안 세션은 단순히 Bedrock Guardrails라는 기능을 소개하는 것을 넘어, GenAI 보안을 어떻게 전략적으로 접근하고, 체계적으로 관리하며, 신뢰성을 확보할 것인가에 대한 실질적인 청사진을 제시한 매우 가치 있는 시간이었습니다.

제가 얻은 가장 큰 인사이트는, GenAI 시대의 ‘Security by Design’은 단순히 보안 기능을 적용하는 것에서 끝나는 것이 아니라, 지속적인 테스트와 검증을 통해 그 효과를 입증하고 최적화하는 동적인 프로세스라는 점입니다. ‘테스트되지 않은 가드레일은 테스트되지 않은 방화벽 룰과 같다’는 비유는 GenAI 보안의 핵심을 관통하는 말이었습니다.

특히, AWS가 제시한 서버리스 기반의 자동화된 테스트 프레임워크 참조 아키텍처는 매우 구체적이고 실용적이었습니다. 이는 가드레일의 정책 튜닝을 더 이상 막연한 감이나 수동 작업에 의존하지 않고, 데이터 기반의 반복적인 개선 활동으로 전환할 수 있는 강력한 도구가 될 것입니다.

결론적으로, 이 세션은 GenAI 도입의 가장 큰 장애물인 ‘보안에 대한 불확실성’을 ‘체계적인 테스트를 통한 확신’으로 바꿀 수 있는 명확한 로드맵을 제공했습니다. 발표에서 제시된 베스트 프랙티스와 자동화 프레임워크를 실제 프로젝트에 적용한다면, 더욱 안전하고 신뢰할 수 있는 GenAI 서비스를 자신 있게 프로덕션 환경에 배포할 수 있을 것이라 확신합니다.

글 │메가존클라우드, HALO, Cloud Security, 김진호 Unit Leader

AWS re:inforce 테크 블로그│모두 보기 👀

이번 AWS re:inforce 테크 블로그는 총 3 편으로 준비하였으니 다른 콘텐츠도 함께 즐겨보세요!

![[실무 가이드] 중국 비즈니스의 시작과 끝: ICP 비안, 왜 선택이 아닌 필수인가?](https://img.iting.co.kr/wp-content/uploads/2026/02/Gemini_Generated_Image_rldc1erldc1erldc.png)

![[유럽 이야기] 소버린 클라우드(Sovereign Cloud)](https://img.iting.co.kr/wp-content/uploads/2026/02/GettyImages-a13565934.jpg)