[AWS SUMMIT 2025] 데이터 사일로 폭파작전: SageMaker Lakehouse로 완성하는 통합 분석과 AI/ML

들어가며

데이터 사일로 폭파작전: SageMaker Lakehouse로 완성하는 통합 분석과 AI/ML

🎙️김성일, 분석 전문 솔루션즈 아키텍트, AWS

🎙️김기영, 솔루션즈 아키텍트, AWS

🗂️ 세션 토픽: 데이터분석현대화

이번 칼럼에서는 Amazon SageMaker Lakehouse 기술을 주제로 한 세션을 듣고, 여러분께 신규 기술과 업데이트된 정보를 공유드리고자 합니다. 이번 세션에서 특히 주목할 내용은 1. 데이터 복제 없이 실시간 공유를 가능하게 하는 제로 카피 공유 모델, 2. Redshift와 Amazon S3를 포함한 다양한 소스를 통합 관리하는 통합 카탈로그 구조, 3. Apache Iceberg 기반의 개방형 API 접근 방식인데요. 이와 함께, 레이크하우스 환경에서의 정교한 권한 관리와 쿼리 처리 방식까지 실용적인 내용이 풍부하게 소개되었습니다.

생성형 AI와 대규모 데이터 분석이 요구되는 시대에, 기존 시스템을 변경하지 않고도 유연하고 안전하게 데이터를 통합하는 방법에 대해 인사이트를 얻을 수 있었는데요. 이러한 주요 내용을 정리하여 여러분께 공유드리겠습니다.

데이터 사일로 문제와 통합의 필요성

요즘 생성형 AI 이야기를 빼놓고는 디지털 전환이나 혁신을 논하기 어려울 정도입니다. 이제는 우리 일상 곳곳에서 생성형 AI를 접할 수 있고, 기업 차원에서 생성형 AI를 비즈니스에 접목하고 새로운 수익 모델을 발굴하는 일도 더 이상 낯선 이야기가 아닙니다.

그렇다면 우리가 실제로 회사에서 생성형 AI 애플리케이션을 한번 만들어 보자는 미션을 받았을 때, 어디서부터 시작하게 될까요? 대부분은 요즘 주목받는 AI 모델을 리서치하고, 테스트하면서 우리 서비스에 적합한 모델을 찾아 인티그레이션 하는 흐름을 따릅니다.

하지만 이 과정을 한번이라도 경험해보신 분들이라면 알 수 있습니다. 단순히 모델을 잘 골라서 적용하는 것만으로는 경쟁사와의 뚜렷한 차별화를 이루기 어렵다는 사실 말이죠. 이제는 ‘우리가 가진 데이터’에 주목해야 할 시점입니다.진짜 경쟁력은 결국 우리 조직이 보유한 데이터에서 시작됩니다. 데이터는 생성형 AI를 움직이는 연료이자, 그 AI의 결과에 차이를 만드는 핵심입니다. 따라서 AI 모델 선택뿐 아니라, 데이터를 어떻게 잘 준비하고 통합하느냐가 중요한 과제가 됩니다. 위 그림처럼, 겉으로 드러나는 AI 모델은 빙산의 일각일 뿐이며, 그 아래 탄탄한 데이터 파운데이션이 갖춰져 있어야 진정한 가치가 실현될 수 있습니다.

사실 기업들도 데이터의 중요성을 오래전부터 인식해 왔습니다. 약 82%의 기업이 CDO(Chief Data Officer)를 임명하고, 전담 조직을 구성했으며, 94%에 이르는 기업들이 데이터 관련 투자를 확대했습니다. 그러나 그럼에도 불구하고 74%의 기업은 데이터에서 인사이트를 도출하는 데 실패했다고 스스로 평가했습니다.

왜 이런 결과가 나왔을까요?

물론 다양한 이유가 있겠지만, 오늘 이 글에서는 그중에서도 ‘데이터 통합’이라는 관점에 주목해 보려고 합니다.

잠시 비유를 들어볼까요? 우리가 다 함께 옷을 사러 간다고 생각해 봅시다. 수많은 사람들이 모두 만족할 수 있는 ‘단 하나의 사이즈’가 존재할 수 있을까요? 아마 없을 겁니다. 데이터도 마찬가지입니다. 모든 데이터를 하나의 시스템에 억지로 몰아넣는다고 해서 최적의 분석 환경이 만들어지지는 않습니다. 조직마다, 서비스마다, 그리고 데이터의 종류마다 적합한 저장소와 처리 방식이 다르기 때문입니다.

우리가 데이터 파이프라인을 설계하고 운영한다고 가정해봅시다. 다양한 소스에서 데이터를 수집하고, 이를 정제한 뒤 어디엔가 저장해야 하죠. 이때 선택지는 보통 데이터 레이크 또는 데이터 웨어하우스입니다. 그렇다면, 언제 데이터를 레이크에 저장하고, 언제 웨어하우스에 저장할까요?

보통은 아래와 같이 구분하는 경우가 많습니다.

- 데이터 레이크

- 유연한 스토리지가 필요한 경우

- 오픈 포맷으로 다양한 엔진을 통해 분석하고 싶은 경우

- 다양한 엔진에서 접근이 필요한 경우

- 데이터 웨어하우스

- 쿼리 성능과 빠른 응답이 중요한 경우

- ADC를 준수해야하는 경우

- 사용성과 구조화된 분석이 중요한 경우

그래서 데이터를 저장하는 사람의 입장에서는 이런 기준에 따라 저장소를 선택하게 됩니다. 하지만, ‘데이터를 사용하는 사람’의 입장에서 생각해보면 이야기가 조금 달라집니다.

데이터 분석가 입장에서 보면, 어떤 데이터는 레이크에, 어떤 데이터는 웨어하우스에 흩어져 있다는 건

결국 데이터가 분산되어 있다, 즉 ‘사일로(Silo)’ 상태다라고 느껴지기 쉽습니다.

이렇게 사일로화된 데이터 환경은 여러 문제를 유발합니다.

- 원하는 쿼리엔진에서 모든 데이터를 접근하기 어려움

- 저장소별로 접근 권한과 인터페이스가 달라 혼란이 생김

데이터를 찾고, 분석하고, 결론을 내기까지 걸리는 엔드 투 엔드 시간이 길어짐

물론 해결책이 간단한 것도 아닙니다. “그럼 모든 데이터를 한 곳에 모으면 되지 않나?”라고 생각할 수도 있지만, 실제로는 그렇게 단순하지 않습니다.

예를 들어 데이터 레이크 중심 아키텍처를 선택하면,

- 트랜잭션 처리 같은 DB 기능은 일부 포기해야 합니다.

- 높은 동시성에서의 쿼리 성능도 제한될 수 있습니다.

- 웨어하우스처럼 자동으로 스토리지를 최적화하는 기능도 부족할 수 있습니다.

반대로 데이터 웨어하우스 중심 아키텍처는,

- 데이터 접근의 자유도나 오픈 포맷 활용 측면에서 제약이 생깁니다.

- 다양한 쿼리 엔진을 쓰는 것도 쉽지 않을 수 있습니다.

Amazon SageMaker Lakehouse 소개

이런 복잡성을 해결하기 위해 등장한 개념이 바로 레이크하우스(Lakehouse)입니다.

레이크하우스는 말 그대로 데이터 레이크의 유연함과 데이터 웨어하우스의 성능과 거버넌스 기능을 결합한 구조입니다. 데이터를 개별 저장소(S3 또는 Redshift 등)로 직접 접근하는 것이 아니라, 레이크하우스라는 통합된 레이어를 통해 일관된 방식으로 데이터를 접근하는 것이 핵심이죠.그리고 이 접근 방식은 특정 벤더만을 위한 전용 인터페이스가 아니라, 오픈 스탠다드 기반으로 설계되었기 때문에 AWS 내부의 다양한 분석 툴은 물론, 외부의 서드파티 분석 엔진에서도 접근이 가능합니다.

AWS 기준으로 보면, 데이터 웨어하우스인 Amazon Redshift와 데이터 레이크인 Amazon S3가 대표적인 저장소입니다. 이 둘을 하나의 관점에서 통합 관리할 수 있도록 만들어진 것이 바로 Amazon SageMaker Lakehouse입니다.

SageMaker Lakehouse는 Redshift 스토리지와 S3 버킷을 등록해 통합된 데이터 뷰를 제공하며, Apache Iceberg API를 통해 표준화된 방식으로 다양한 툴과 분석 엔진에서 데이터에 접근할 수 있게 합니다. 또한 데이터가 통합되어 있어 세분화된 보안 및 권한 설정이 가능하며, 기존 데이터 아키텍처를 변경하지 않고도 즉시 도입할 수 있다는 점이 큰 장점입니다.

기업 내부의 저장소뿐 아니라, 다양한 외부 애플리케이션과 서비스의 데이터도 효율적으로 통합할 수 있도록 지원합니다.

- Amazon Aurora, RDS 등 AWS DB → Zero-ETL로 자동 연동

- Salesforce, Zendesk, ServiceNow 등 SaaS → Zero-ETL 기반 연동

- BigQuery, Snowflake, Oracle 같은 외부 엔진 → Federated Query로 연동

저장소 수준에서 데이터가 SageMaker 레이크하우스를 통해서 관리가 된다고 하면, 분석/머신러닝 등 실질적인 분석 업무를 수행하는 환경 역시 통합되어야겠죠?

그래서 함께 출시된 서비스가 바로 Amazon SageMaker Unified Studio입니다. 기존의 AWS 콘솔과는 다른 전용 웹 포털을 통해 “데이터 처리, SQL 분석. 머신러닝 모델 개발, 생성형 AI 워크플로우” 이 모든 과정을 하나의 환경 안에서 실행할 수 있습니다. 특히 레이크하우스와 완벽하게 통합되어 있어, 데이터 과학자, 분석가, 엔지니어, 개발자 등 다양한 페르소나들이 각자의 역할에 맞는 툴을 동일한 UI·UX 환경에서 사용할 수 있게 됩니다.

유연한 스토리지 – 워크로드에 적합한 스토리지 선택

Amazon SageMaker Lakehouse에서 사용할 수 있는 스토리지 옵션 세 가지를 정리해 보겠습니다.

1. Amazon S3

기본적인 스토리지 옵션으로, S3 버킷에 데이터를 저장하고 AWS Glue Data Catalog 등을 연동하면 레이크하우스에서 해당 데이터를 조회할 수 있습니다. Apache Iceberg API를 사용하면 AWS 서비스뿐만 아니라 서드파티 분석 도구에서도 표준화된 방식으로 데이터를 손쉽게 접근할 수 있다는 장점이 있습니다.

2. Amazon S3 Tables

S3 Tables는 Apache Iceberg 기반의 트랜잭셔널 데이터 레이크를 AWS가 완전관리형(Managed)으로 제공하는 서비스입니다. 기존 S3 대비 약 10배의 TPS(초당 트랜잭션 수)와 3배 수준의 쿼리 성능 향상이 가능하며, Iceberg 테이블 운영 시 발생하는 컴팩션(compaction), 스냅샷 정리 같은 작업들도 AWS가 자동으로 처리해 줍니다. 더 나은 성능과 관리 편의성이 필요한 경우 적합한 선택지입니다.

3. Amazon Redshift Managed Storage (RMS)

이미 Redshift를 활용 중인 조직이라면, Redshift의 관리형 스토리지를 SageMaker Lakehouse에 직접 등록해 활용할 수 있습니다. 또는 새로운 데이터를 저장할 때도 RMS를 선택해 카탈로그에 등록이 가능합니다.

RMS를 사용하면 실시간 스트리밍 처리, 강력한 트랜잭션 지원, 고성능 쿼리 처리, ML 기반 워크로드 최적화 등 Redshift의 장점을 레이크하우스 내에서도 그대로 활용할 수 있다는 점이 큰 장점입니다.

통합된 기술 카탈로그 – 유연한 다단계 계층 구조

다음은 Amazon SageMaker Lakehouse의 통합 카탈로그 및 접근 제어 기능에 대한 주요 내용을 정리해 보겠습니다.

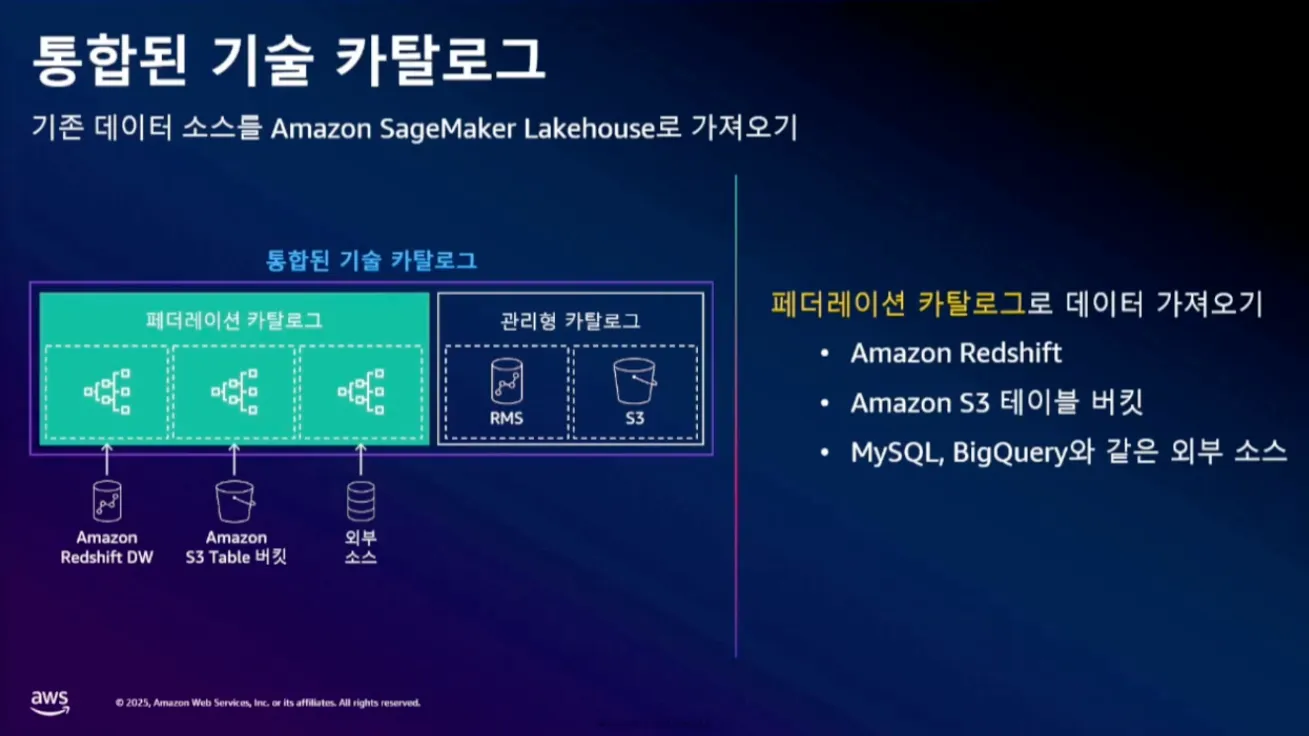

통합된 기술 카탈로그

데이터 레이크 환경에서 일반적으로 데이터를 S3 같은 스토리지에 저장한 후, 카탈로그에 테이블로 등록하고 쿼리 엔진을 통해 분석하는 방식이 사용됩니다. 레이크하우스에서는 이를 더욱 유연하게 만들기 위해 통합 카탈로그 기능을 제공합니다. 통합 카탈로그는 AWS Glue Data Catalog를 확장한 개념이며, 크게 아래와 같이 두 가지 유형으로 구성됩니다

- 관리형 카탈로그 (Managed Catalog): S3, S3 Tables, Redshift Managed Storage(RMS)와 같이 AWS 내부의 스토리지를 지원.

2. 페더레이션 카탈로그 (Federated Catalog): MySQL, BigQuery, 외부 Redshift 등 외부 데이터 소스를 연결해 사용하는 방식.

이 두 카탈로그는 모두 통합 카탈로그 하에 연결되기 때문에, 소스가 어디에 있든지 관계없이 단일 쿼리 뷰로 데이터 분석이 가능합니다.

다중 카탈로그 계층 구조

외부 소스들은 각자의 카탈로그 체계를 갖고 있어 이를 통합하려면 매핑이 필요합니다. 레이크하우스는 자동으로 이러한 구조를 다음과 같이 변환하여 카탈로그에 연결합니다

- 네임스페이스 → 상위 카탈로그

- 데이터베이스 → 하위 카탈로그

- 스키마 → 데이터베이스

- 테이블 → 테이블

위와 같이 매핑된 후에는 SELECT * FROM namespace.database.schema.table 이런 식으로 쿼리를 사용할 수 있습니다.

통합된 접근 제어

통합 카탈로그는 다단계 접근 제어(Access Control) 기능을 제공합니다

- 세분화된 접근 제어: 테이블, 컬럼, 로우(WHERE 절 필터링), 셀(Cell-level)까지 제어 가능

- 태그 기반 접근 제어(TBAC): 정책 태그(Tag-based access control) 방식으로 권한 정의

- 예: 특정 테이블에 ‘PII’ 태그를 지정하고, 해당 태그에 접근 가능한 사용자만 데이터를 조회

- 룰 기반 데이터 접근(RBAC)

제로 카피(Zero copy) 데이터 공유 모델

조직 간 또는 기업 간 데이터 공유가 활발해지면서, 데이터의 신뢰성과 비용 문제를 해결하기 위한 방식으로 제로 카피 데이터 공유가 주목받고 있습니다.

이는 데이터를 복제하지 않고, 원본 데이터에 직접 접근해 사용할 수 있는 방식으로, 데이터의 최신성과 일관성을 유지하면서도 불필요한 저장 비용을 절감할 수 있습니다. 접근 제어 정책을 기반으로 안전하게 공유되며, 특히 대규모 데이터 환경에서 효율적인 데이터 협업을 가능하게 합니다.

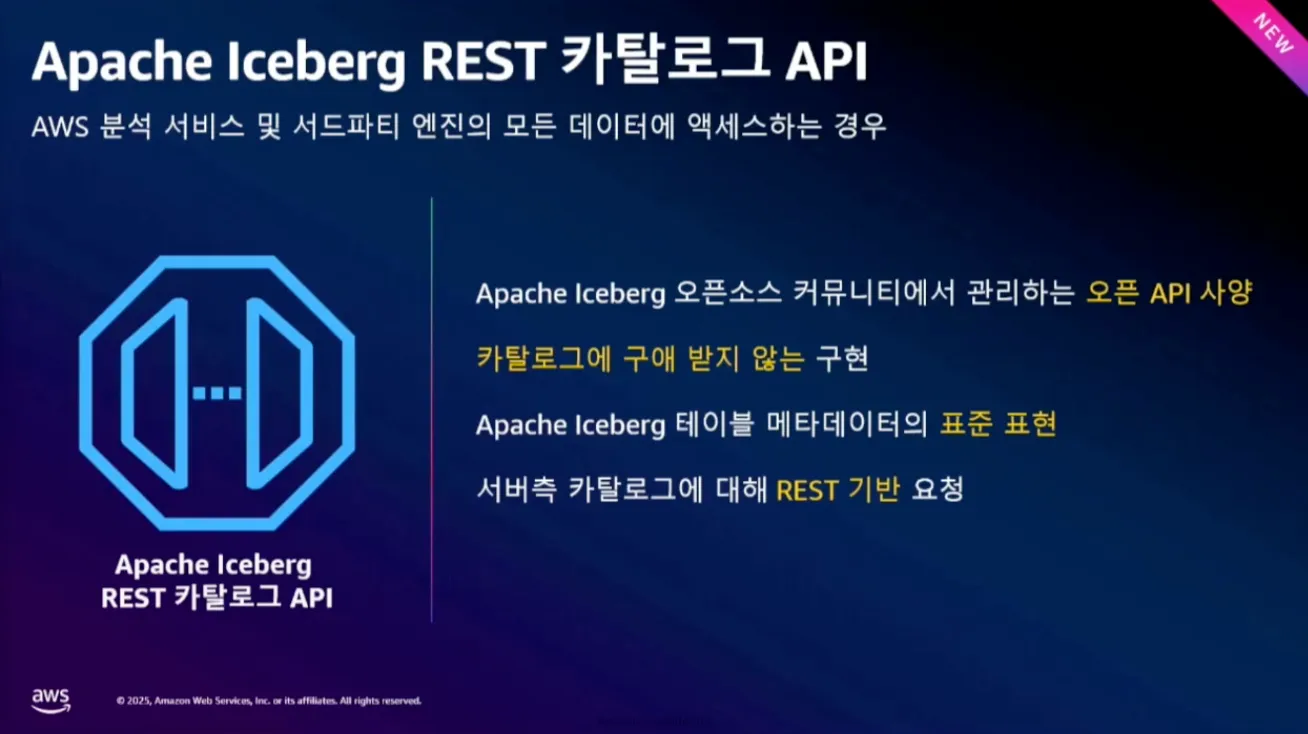

개방형 접근 – Apache Iceberg API

레이크하우스에서 데이터를 활용하기 위해서는 스토리지, 카탈로그, 권한이 잘 연동되어 있어야 하며, 그 위에서 카탈로그에 접근해 데이터를 분석하게 됩니다. 이때 레이크하우스는 Apache Iceberg의 REST Catalog API를 통해 다양한 쿼리 엔진과의 연결을 지원합니다.

예를 들어 AWS Athena, EMR, Redshift, 또는 오픈소스 기반의 Spark 등 어떤 쿼리 엔진이든 Iceberg API를 통해 동일한 방식으로 데이터 카탈로그에 접근할 수 있습니다.

이 API는 RESTful 서비스 기반으로 설계되어 있어, 특정 언어나 플랫폼에 종속되지 않고 벤더 독립적인 개방형 표준을 따릅니다. Iceberg 라이브러리만 사용하면 카탈로그에 쉽게 접근할 수 있고, 명확한 스펙이 존재하기 때문에 향후 다른 환경으로 이전하더라도 일관성 있게 마이그레이션할 수 있다는 장점도 있습니다. 레이크하우스는 바로 이 Iceberg API를 활용해 유연하고 확장성 있는 데이터 접근 환경을 제공합니다.

마무리하며

이번 세션에서는 Amazon SageMaker Lakehouse의 아키텍처 구성과 통합 카탈로그, 접근 제어, 쿼리 방식 등 데이터 레이크하우스를 구성하는 핵심 기능들을 실제 데모와 함께 살펴볼 수 있었습니다. 특히 인상 깊었던 부분은 데이터를 사용하는 분석가의 입장에서 다양한 스토리지와 데이터 소스를 하나의 통합된 환경에서 분석할 수 있다는 점이었습니다. 분석 대상이 어디에 있든 통합 카탈로그를 통해 손쉽게 접근하고 쿼리 할 수 있다는 점은 실무에서 큰 생산성 향상을 기대하게 합니다.

또한 Redshift를 Glue 데이터 카탈로그에 등록하고, Lake Formation을 통해 접근 권한을 승인하는 방식은 매우 직관적이고 실용적인 접근 방식이라는 인사이트를 얻을 수 있었습니다. 개방형 API 기반으로 다양한 쿼리 엔진에서도 통일된 방식으로 접근 가능한 구조는 사용자 중심의 데이터 플랫폼 구성에 큰 강점으로 느껴졌습니다.

이러한 내용은 많은 고객사들이 실제로 데이터 분석 환경 구축 과정에서 겪는 복잡성과 분산된 관리의 어려움을 해결하는 데 실질적인 도움이 될 수 있을 것으로 기대됩니다.

글 │ 메가존클라우드, AI & Data 부문 / AI & Data Ops, 김은옥 매니저

AWS SUMMIT 2025

전문가의 시선으로 정리된 테크 블로그를 통해

2025년 IT 트렌드의 현재와 미래를 살펴보세요.

테크 블로그 목차 (바로 가기→)

![[유럽 이야기] 소버린 클라우드(Sovereign Cloud)](https://img.iting.co.kr/wp-content/uploads/2026/02/GettyImages-a13565934.jpg)

![[미국 이야기] 골든 돔(Golden Dome)이 한국 AI시장에 미치는 영향에 대하여](https://img.iting.co.kr/wp-content/uploads/2025/01/USA_thumbnail_GettyImagesEdge_Editor_Cut_1454217037.png)